使用MLX调用Phi-4模型

在当今的AI技术浪潮中,微软推出的Phi-4模型无疑是一个令人瞩目的创新。作为小型语言模型(SLM)的最新成员,Phi-4以其14B参数的强大性能和卓越的复杂推理能力,展示了AI技术在数学、编程和长文本处理等领域的巨大潜力。本文将详细介绍如何使用MLX框架调用Phi-4模型,并探讨其在不同应用场景中的实际效果。

一、Phi-4模型简介

Phi-4是微软推出的最新小型语言模型,专注于复杂推理任务,如数学问题解决、编程任务和长文本处理。尽管其参数规模相对较小,但通过高质量的合成数据训练和创新的后训练技术,Phi-4在多个基准测试中取得了优异的成绩。例如,在美国数学竞赛AMC 10/12中,Phi-4的表现超过了90分。此外,Phi-4还展示了出色的长文本处理能力,能够处理长达16K的上下文,并保持高召回率。

二、MLX框架概述

MLX是苹果公司推出的一款开源机器学习框架,专为Apple芯片设计,支持多种经典模型的训练和推理。MLX框架不仅兼容最新的Phi-4模型,还提供了灵活的API接口,使得开发者可以在Mac等设备上轻松进行深度学习任务。与传统的PyTorch等框架相比,MLX在资源消耗和计算效率方面具有显著优势,特别是在处理小型模型时表现尤为突出。

三、使用MLX调用Phi-4模型的步骤

1. 安装MLX

首先,需要在本地环境中安装MLX框架。可以通过以下命令完成安装:

|

|

2. 下载Phi-4模型

Phi-4模型可以通过Azure AI Foundry或Hugging Face平台获取。建议访问Azure AI Foundry进行注册并下载模型。

3. 准备数据集

为了训练或微调Phi-4模型,需要准备相应的数据集。MLX支持多种数据格式,包括JSONL格式。可以从GitHub或其他资源库下载数据集。

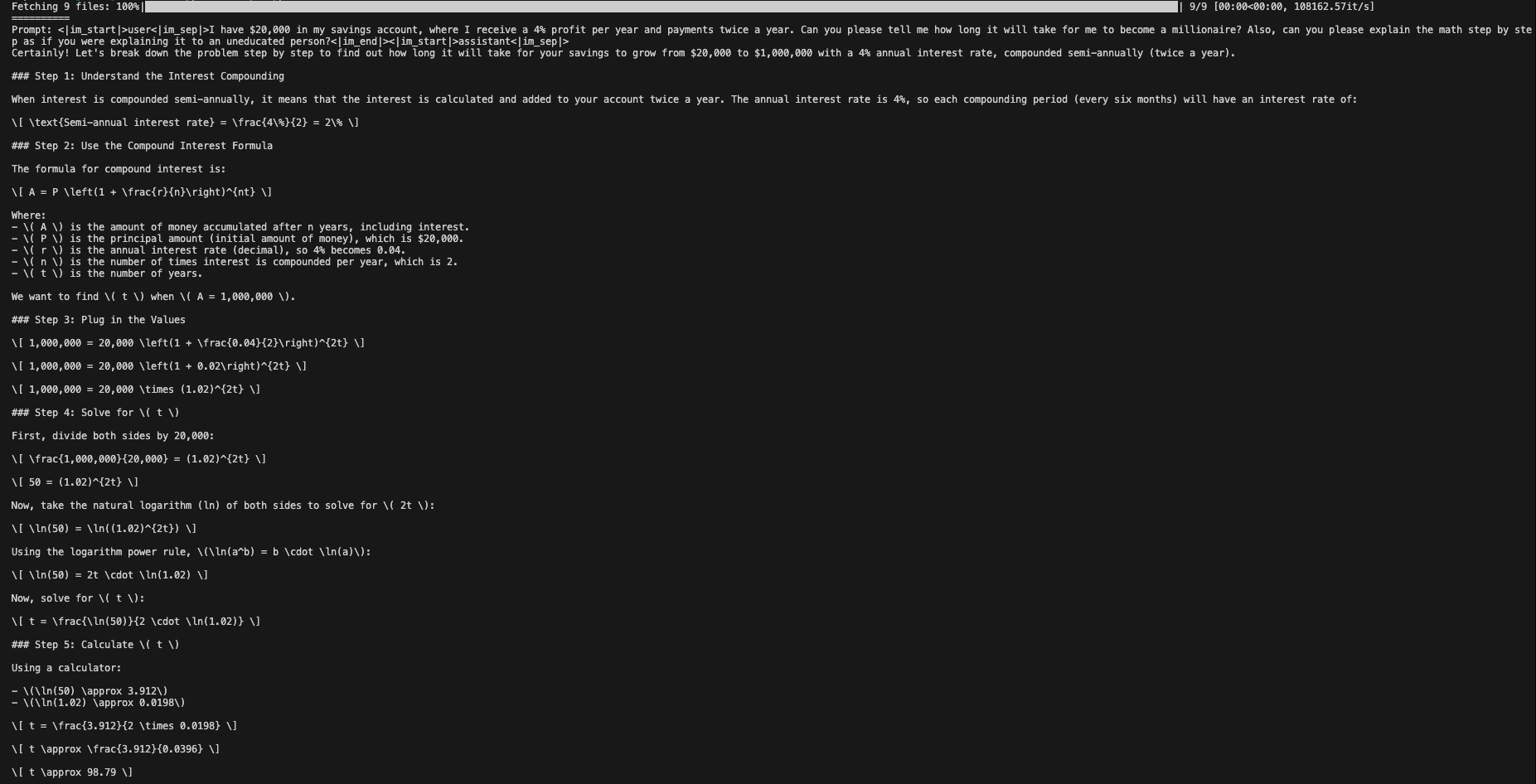

4. 使用MLX进行推理

一旦数据准备就绪,可以使用MLX进行推理。以下是一个简单的推理示例:

|

|

或者使用Python代码:

|

|

此命令将使用Phi-4模型生成一段文本响应。

5. 微调Phi-4模型

如果需要对Phi-4进行微调以适应特定任务,可以使用MLX提供的LoRA(Low-Rank Adaptation)技术。以下是微调的基本步骤:

|

|

通过上述命令,可以在本地环境中对Phi-4模型进行微调,以提升其在特定任务上的表现。

四、Phi-4的应用场景

Phi-4模型在多个领域展现了广泛的应用潜力:

-

教育辅助:作为教育辅助工具,Phi-4可以帮助学生解答STEM领域的复杂问题,提供数学和编程作业的辅导。

-

技术研究:在科学研究中,Phi-4可以辅助研究人员进行文献综述和数据分析,提高研究效率。

-

软件开发:Phi-4能够辅助软件开发,包括代码生成、调试和功能实现。

-

智能助手:作为智能助手,Phi-4可以理解和响应用户的查询,提供信息检索、日程管理和其他个人助理服务。

-

企业决策支持:通过分析大量数据,Phi-4为企业提供市场趋势分析、风险评估和决策支持。

五、总结

Phi-4模型凭借其强大的推理能力和高效的资源利用,在AI领域树立了新的标杆。通过MLX框架,开发者可以轻松地在Mac等设备上部署和使用Phi-4模型,从而实现复杂任务的高效处理。无论是教育、科研还是商业应用,Phi-4都展现出了巨大的潜力。未来,随着技术的不断进步,我们有理由相信Phi-4将在更多领域发挥重要作用。

六、参考资料

- Azure AI Foundry: https://azure.microsoft.com/zh-cn/services/ai/

- lokinfey/Phi-4-mlx-int4: https://huggingface.co/lokinfey/Phi-4-mlx-int4

- MLX: https://github.com/ml-explore/mlx

- 原文作者:BeanHsiang

- 原文链接:https://beanhsiang.github.io/post/2024-12-10-phi-4-with-mlx/

- 版权声明:本作品采用知识共享署名-非商业性使用-禁止演绎 4.0 国际许可协议. 进行许可,非商业转载请注明出处(作者,原文链接),商业转载请联系作者获得授权。